Services on Demand

Journal

Article

Indicators

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO

Share

Ciência e Cultura

On-line version ISSN 2317-6660

Cienc. Cult. vol.67 no.4 São Paulo Oct./Dec. 2015

http://dx.doi.org/10.21800/2317-66602015000400003

BRASIL

POLÍTICA DE C&T

Em revisão: o impacto da produção científica brasileira para o Brasil

Germana Barata

Nos anos 1960, Eugene Garfield desenvolveu indicadores para organizar e avaliar referências bibliográficas da área de medicina, com o objetivo de minimizar a subjetividade humana na seleção e indexação de obras e aumentar a eficiência da busca por informações relacionadas a um tema de pesquisa. Garfield fundou o Institute of Scientific Information (ISI) e influentes bases de dados internacionais, como o Web of Science (WoS) que reúne uma seleta gama de revistas científicas e divulga indicadores como o fator de impacto (FI) - média de citações que os artigos de uma revista recebe nos dois anos anteriores. Mais do que meras ferramentas, os indicadores acabaram se tornando metas para as políticas científicas.

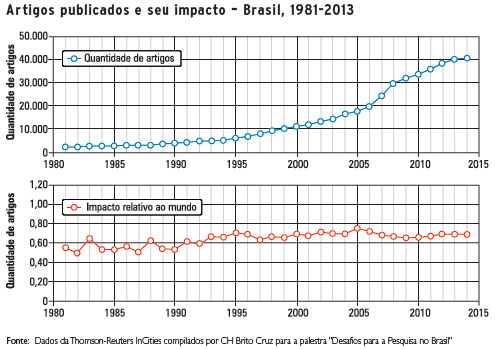

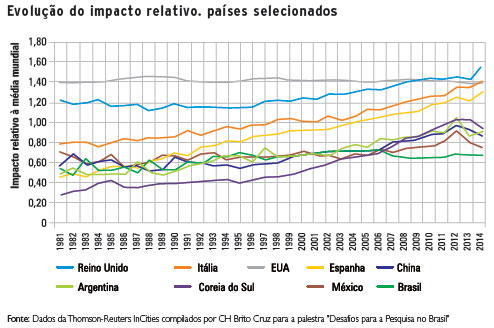

Apesar de a ciência brasileira estar crescendo acima da média mundial nos últimos anos - sobretudo a partir dos anos 1990, a participação do país na produção científica internacional passou dos apenas 1% para 2,5%, em 2013 - permanece a queixa de que o número de citações dos artigos brasileiros no exterior se manteve estável. Assim, a meta dos últimos anos não é aumentar a quantidade de artigos, mas sua qualidade, traduzida pelo número de citações de artigos de autores brasileiros indexados nos consagrados Scopus, da editora holandesa Elsevier, e WoS.

Para Lea Velho, especialista em estudos sociais da ciência do Instituto de Geociências da Universidade Estadual de Campinas (Unicamp), os fatores que levam uma pessoa a citar um artigo não têm relação com a sua qualidade. "É como se estivéssemos induzindo as pessoas a acharem que aqueles números [citações] refletem qualidade. A citação é um ato social, não de mérito", afirma Lea, que nos anos 1980 publicou artigos sobre a prática de citação. Ao mesmo tempo ela lembra uma das regras básicas da cienciometria na qual as comparações só valem se compararem iguais com iguais, ou seja, as mesmas áreas do conhecimento e não a soma de todas elas em nações diferentes. "Não há nenhum problema de usarmos esses indicadores como suporte a processos de avaliação. O que não concordamos é com o uso indiscriminado", conclui Jacqueline Leta, professora adjunta do Instituto de Bioquímica Médica da Universidade Federal do Rio de Janeiro (UFRJ) e que se dedica aos estudos de cienciometria.

INDUZINDO MUDANÇAS

Outra regra da cienciometria é que os indicadores de produção científica acabam modelando comportamentos, como o aumento no número de publicações, independentemente da qualidade e o direcionamento da pesquisa para temas de maior visibilidade internacional, por exemplo, o que contribui para efeitos deletérios ao sistema. Talvez essa tenha sido uma das razões pela qual a Austrália extinguiu, em 2011, seu sistema de classificações de revistas científicas. A classificação era controversa para inúmeras áreas, por exemplo, as multidisciplinares, as novas e aquelas com ênfase mais regional, que acabavam prejudicadas com o ranking. O país preferiu deixar que cada área determinasse suas prioridades de publicação.

As classificações também influenciam a percepção de que os bons artigos estão apenas nas revistas melhor colocadas. "Não temos necessariamente que publicar em revistas de mainstream e ser citados no exterior! Esse não é o objetivo da política. Precisamos é produzir conhecimento para saber resolver os problemas que temos", defende Lea Velho.

NACIONALMENTE RELEVANTE

Quando a ênfase são os indicadores internacionais, como fica a produção científica brasileira que não pode ser contabilizada a partir dessas bases de dados, como, por exemplo, a de áreas do conhecimento que tradicionalmente publicam em português? Leta estima que existam cerca de mil revistas científicas no Brasil. Destas, cerca de 400 estão indexadas em bases como a brasileira SciELO (Scientific Eletronic Library Online), mas ainda há inúmeras outras publicações indexadas, por exemplo, nos 162 portais de periódicos científicos listados pelo Instituto Brasileiro de Informação em Ciência e Tecnologia (Ibict) que usam o Sistema Eletrônico de Editoração de Revistas (SEER) e outras tantas ainda não indexadas. "Quem não está indexado não tem indicador", resume Rogério Mugnaini, cientista da informação da Universidade de São Paulo (USP), que tem se dedicado a estudar indicadores para a produção nacional. Ele propõe o desenvolvimento de indicadores que levem em consideração as especificidades de cada área do conhecimento e que considerem também as publicações que não estão indexadas no SciELO ou nos principais indexado-res estrangeiros. O principal é "ver o que é importante para os brasileiros". Segundo ele, a combinação de indicadores de impacto nacionais e internacionais valoriza a produção local.

O atual sistema de avaliações de cursos de pós-graduação, desenvolvido pela Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (Capes), classifica, desde 2001, as revistas científicas brasileiras, constituindo-se como um dos indicadores de qualidade. A classificação Qualis Periódicos acaba definindo as escolhas na hora de publicar um artigo, bem como cria a percepção de que ela reflete a qualidade, não apenas das revistas, mas dos próprios artigos. Há inúmeras inconsistências, no entanto, que colocam o sistema no epicentro da polêmica na academia. Dentre elas o fato de colocar nos principais estratos, A1 e A2, lado a lado, revistas brasileiras, com menor rigor de avaliação, e publicações internacionais, com critérios claros e rigorosa avaliação por pares, não incluir revistas importantes para a área do conhecimento, ou conferir notas mais baixas para publicações interdisciplinares ou muito especializadas.

Mugnaini avaliou os tipos de critério de avaliação adotados no Qualis Periódicos para definição nos estratos mais altos (A1, A2 e B1) nas diferentes áreas do conhecimento e constatou que "a maioria das áreas duras apresenta um perfil de avaliação baseado estritamente em indicadores bibliométricos, principalmente o fator de impacto do JCR e em alguns casos, o índice H. Já as áreas de humanas, sociais e linguística, letras e artes, por sua vez, apoiam-se no processo de seleção realizado pelas bases de dados, principalmente os índices de citação (WoS, Scopus e SciELO), e também em outras bases como RedALyC e Latindex". Isso quer dizer que mesmo as áreas menos internacionalizadas, se baseiam em critérios internacionais.

Segundo Leta o Brasil está se aproximando de um estágio máximo da produção científica, o chamado steady state, com a limitação de nossa capacidade produtiva refletida, sobretudo na pós-graduação. Talvez seja o momento ideal de pensar em uma reformulação nas prioridades de produção científica e seus critérios de avaliação, de modo a investir em qualidade e não simplesmente para aumentar os indicadores internacionais, restritos a dois repositórios.

FACA DE DOIS GUMES

O desejo de aumentar o número de citações de publicações brasileiras no exterior tem sido defendido por financiadoras de pesquisa, como a Fapesp e Capes, que, de um lado, utilizam como referência os indicadores internacionais como o fator de impacto e, por outro, investem nas publicações de acesso aberto (gratuito para publicar e acessar o conteúdo), como os investimentos no SciELO, mas exigem critérios de indexação cada vez mais internacionais. As publicações dos estratos mais baixos do Qualis Periódicos têm cada vez menos chances de conseguirem mais e melhores artigos para galgarem melhores posições. Nessa política de duas vias, acaba-se criando uma desvantagem para as revistas relevantes para o cenário nacional publicadas sobretudo em português, as novatas, as que não estão indexadas, entre outras. Em artigo que analisa o sistema de avaliação e classificação dos periódicos científicos brasileiros, publicado na revista Pensata (vol.4, no.2, 2015), Jean Carlos Ferreira, Marko Monteiro e Monica Frigeri, sugerem um caminho para equacionar essa delicada questão: "A avaliação da ciência, ainda que necessária, precisaria desenvolver formas de julgamento e mensuração da atividade científica mais refinadas, que levem em conta a diversidade de práticas de publicação, sem perder de vista que a própria avaliação da ciência ajuda a direcionar a prática científica".